Déjouer l’incertitude : Optimisation de politiques dans les POMDP continues grâce à Monte Carlo séquentiel

Déjouer l’incertitude : Optimisation de politiques dans les POMDP continues grâce à Monte Carlo séquentiel

La prise de décision optimale en situation d’observabilité partielle exige des agents de trouver un équilibre entre la réduction de l’incertitude (exploration) et la poursuite d’objectifs immédiats (exploitation). Un nouvel article explore une approche innovante pour résoudre ce défi dans le contexte des processus décisionnels markoviens partiellement observables (POMDP) continus.

Une approche probabiliste pour la prise de décision

L’article présente un cadre d’optimisation de politique novateur. Au lieu d’approches traditionnelles, il reformule l’apprentissage des politiques comme un problème d’inférence probabiliste dans un modèle de Feynman-Kac non markovien. Ce modèle capture intrinsèquement la valeur de la collecte d’informations en anticipant les observations futures, sans avoir besoin de bonus d’exploration externes ou d’heuristiques artificielles. Imaginez un robot explorant un environnement inconnu : cette méthode lui permet de décider intelligemment où regarder ensuite en fonction de ce qu’il pourrait apprendre, plutôt que de se fier à des règles prédéfinies.

Optimisation via Monte Carlo séquentiel

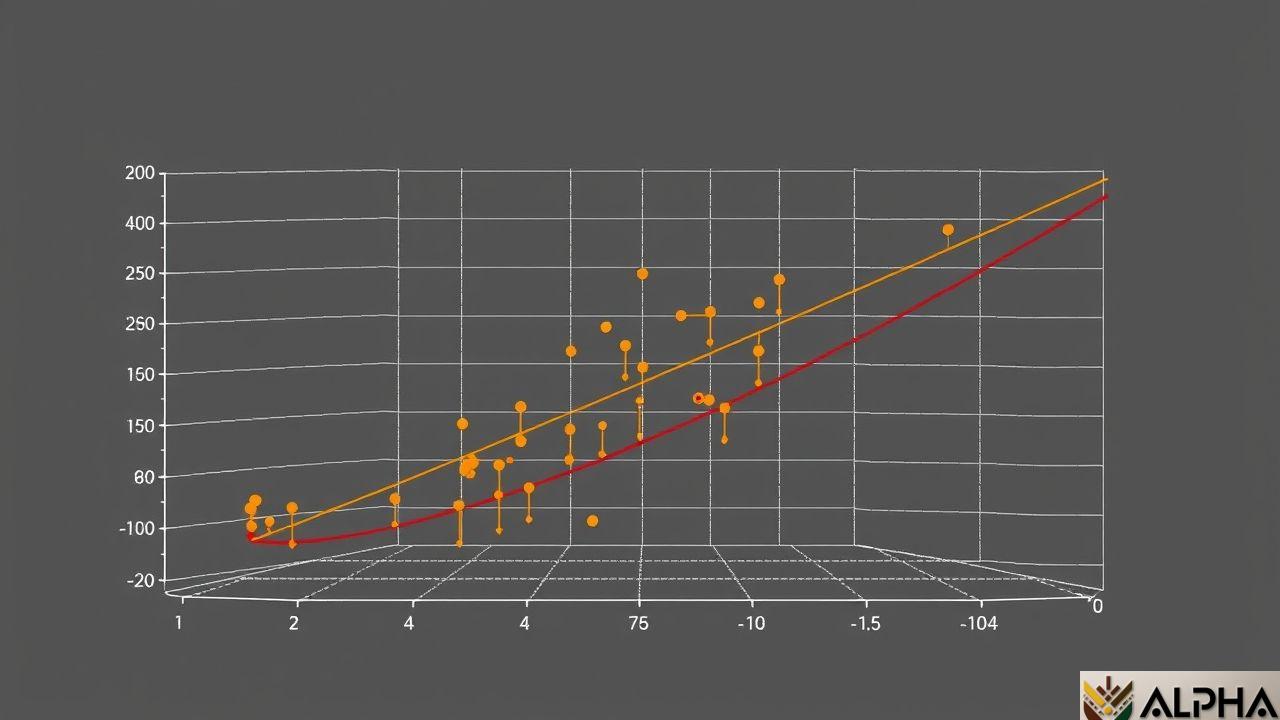

Pour optimiser les politiques selon ce modèle, les chercheurs développent un algorithme de Monte Carlo séquentiel imbriqué. Cet algorithme estime efficacement un gradient de politique dépendant de l’historique à partir d’échantillons de la distribution de trajectoires optimales induite par le POMDP. La complexité est gérée grâce à une approche séquentielle qui traite les informations de manière incrémentale, ce qui le rend plus adapté aux environnements complexes et aux problèmes à grande échelle.

Résultats et perspectives

Les résultats expérimentaux sur des benchmarks POMDP continus standard montrent la supériorité de l’algorithme proposé par rapport aux méthodes existantes. Il surpasse les approches traditionnelles, notamment dans les situations où l’incertitude est élevée. Cela ouvre des perspectives intéressantes pour le développement d’agents plus robustes et capables de prendre des décisions éclairées dans des environnements incertains. L’application à des problèmes concrets, comme la robotique, la conduite autonome ou la gestion de ressources, est une perspective passionnante.

Points clés à retenir

- ✓ Une nouvelle approche pour l’optimisation de politiques dans les POMDP continus, basée sur l’inférence probabiliste.

- ✓ Un algorithme de Monte Carlo séquentiel imbriqué pour estimer efficacement le gradient de politique.

- ✓ Des résultats prometteurs sur des benchmarks standards, surpassant les méthodes existantes.

- ✓ Des perspectives d’application concrètes dans divers domaines.

Sources

Share this content:

Laisser un commentaire