L’IA au bord du réseau : Modèles, métriques et compromis

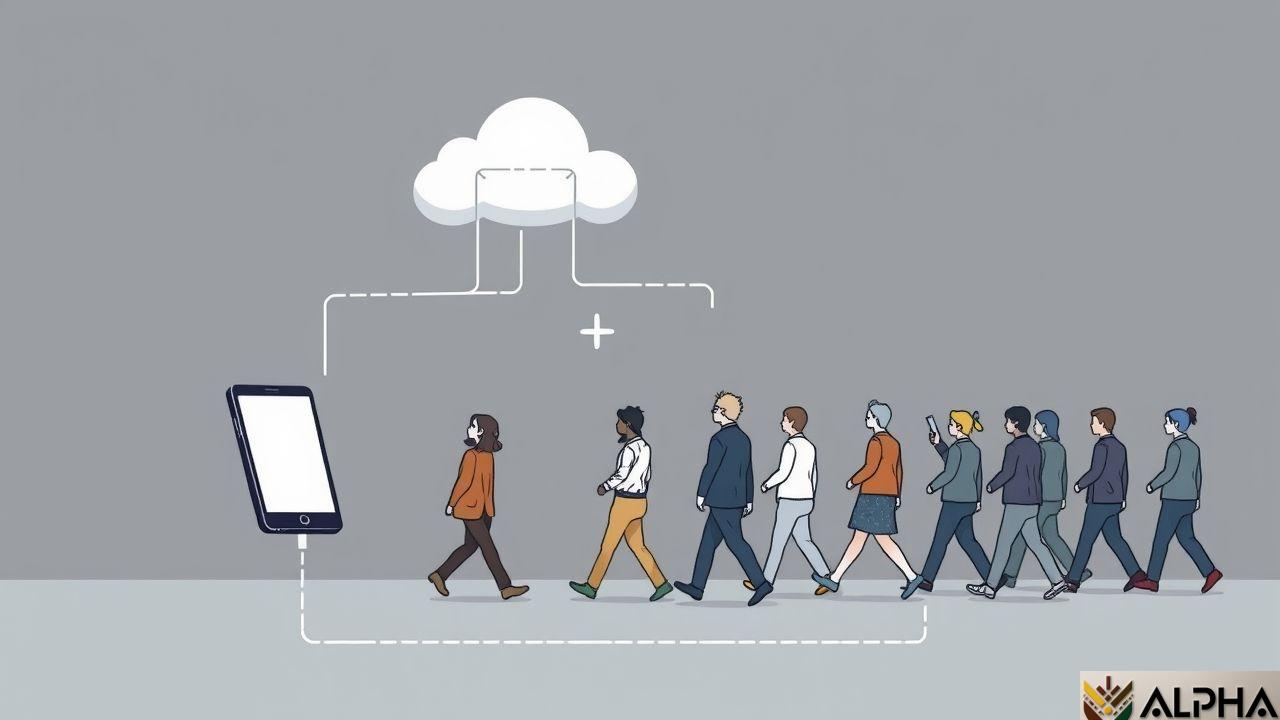

L’essor fulgurant des modèles linguistiques (LLM) transforme le paysage numérique, poussant les entreprises à les déployer sur tout le spectre informatique, du cloud à la périphérie du réseau. Cette migration vers l’edge computing vise à réduire les coûts, à diminuer la latence et à améliorer la fiabilité et la confidentialité des données. Les petits modèles linguistiques (SLM), fruit des progrès en matière de compression de modèles, jouent un rôle crucial dans cette transition, ouvrant la voie à l’inférence sur des appareils aux ressources limitées.

Benchmarking des SLM : Performances comparées

Cette étude analyse l’interaction entre les déploiements en edge et dans le cloud. Elle commence par une évaluation détaillée des capacités des SLM sur des appareils edge individuels, puis s’étend à des clusters edge distribués. Des benchmarks précis révèlent des scénarios où l’inférence edge offre des performances comparables à moindre coût. D’autres scénarios, cependant, soulignent les limites de la scalabilité ou de la capacité des modèles, nécessitant un repli sur le cloud.

L’inférence adaptative : un équilibre délicat

Au lieu d’une solution unique, l’étude met en avant des comparaisons au niveau de la plateforme et des éléments de conception pour construire des systèmes d’inférence LLM efficaces et adaptatifs dans des environnements hétérogènes. Imaginons une application de traduction en temps réel en Afrique : un SLM déployé sur un smartphone pourrait traduire des phrases courtes instantanément, tandis que des traductions plus complexes pourraient être acheminées vers un serveur cloud plus puissant. Ce système hybride optimise l’expérience utilisateur et gère efficacement les ressources.

Scalabilité et capacité des modèles: Le cloud comme solution de secours

La scalabilité reste un défi majeur pour l’inférence edge. Si le traitement d’un grand nombre de requêtes simultanées dépasse les capacités d’un cluster edge, le cloud sert de solution de secours. Ce mécanisme de basculement assure la continuité du service, même en cas de forte demande. Un exemple concret pourrait être une plateforme d’analyse de données météorologiques en Afrique subsaharienne : des stations météorologiques locales pourraient effectuer un traitement préliminaire des données sur des SLM, envoyant ensuite les données complexes vers le cloud pour une analyse plus approfondie.

Points clés et perspectives

- ✓ L’inférence edge offre des avantages en termes de coût et de latence pour certaines applications.

- ✓ Les SLM sont essentiels pour l’inférence edge sur des appareils à ressources limitées.

- ✓ Un système hybride edge/cloud offre une solution plus robuste et adaptable.

- ✓ La scalabilité et la capacité des modèles restent des défis importants pour le déploiement edge.

Share this content:

Laisser un commentaire