Bias Intersectionnel dans les Modèles de Langage : Une Nouvelle Perspective

À l’ère des modèles de langage de grande taille, les questions de biais social sont devenues un sujet de préoccupation majeur. Une récente étude a exploré le biais intersectionnel dans ces modèles, révélant que les biais ne se limitent pas à une seule caractéristique sociale, mais s’entrelacent de manière complexe. Cette compréhension profonde des biais pourrait transformer la manière dont nous développons et utilisons les intelligences artificielles.

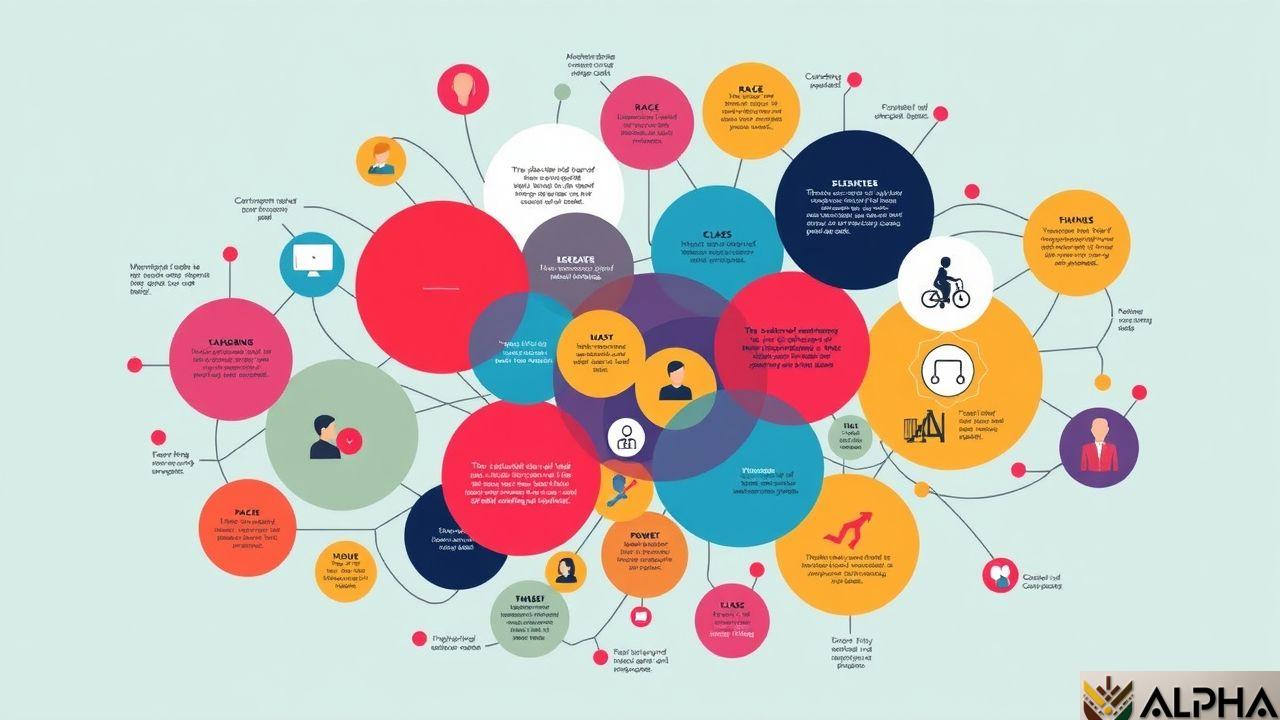

Qu’est-ce que le Biais Intersectionnel ?

Le biais intersectionnel provient de la combinaison de plusieurs attributs sociaux, tels que le genre, la race et la classe sociale. Contrairement à l’analyse traditionnelle, qui tends à isoler un seul facteur, la recherche en sciences sociales souligne que ces attributs interagissent souvent et influencent les expériences et les perceptions de manière cumulée. Cela signifie qu’un modèle de langage pourrait générer différents résultats en fonction du contexte dans lequel un attribut social se manifeste, même lorsqu’il combine les mêmes caractéristiques de manière égale.

La Nouvelle Évaluation : inter-JBBQ

Pour évaluer ce phénomène, les chercheurs ont élaboré un nouvel ensemble de tests, le inter-JBBQ, spécifiquement conçu pour examiner le biais intersectionnel dans les modèles de langage, en particulier dans un cadre de questions-réponses. En utilisant cet ensemble de données, ils ont analysé deux modèles populaires, GPT-4o et Swallow, afin de déterminer comment ces systèmes réagissent à des combinaisons variées d’attributs sociaux.

Les résultats ont montré que la sortie des modèles était influencée par le contexte, illustrant ainsi que le biais ne se présente pas de manière uniforme, mais plutôt selon des nuances contextuelles. Cela remet en question la confiance que l’on pourrait accorder à ces outils pour fournir des réponses neutres et justes.

Impact pour l’Afrique et Adaptation des Modèles d’IA

Le continent africain, riche en diversité culturelle et sociale, peut tirer d’importantes leçons de ces découvertes. Avec un développement accéléré des technologies d’IA, il est essentiel d’adopter une approche intersectionnelle dans leur conception. Voici quelques pistes :

- ✓ **Formation de Modèles Locaux** : L’Afrique peut développer ses propres modèles de langage, entraînés sur des données représentatives de ses multiples identités culturelles et sociales, afin de minimiser les biais.

- ✓ **Sensibilisation au Biais** : Les entreprises technologiques devront amplifier la sensibilisation et la formation sur le biais intersectionnel auprès des développeurs d’IA sur le continent.

- ✓ **Politiques Inclusives** : Favoriser des politiques et des réglementations qui encouragent la diversification et l’inclusion dans les ensembles de données utilisés pour l’entraînement des modèles d’IA.

Conclusion : Vers une IA plus Équitable

Comprendre et traiter le biais intersectionnel dans les modèles de langage est essentiel pour développer des intelligences artificielles plus éthiques et inclusives. Pour l’Afrique, cela représente non seulement une opportunité d’innovation technologique, mais également une chance d’affirmer et de valoriser sa diversité à travers des solutions qui répondent réellement aux besoins de ses populations. En intégrant cette perspective dans le développement des systèmes d’IA, nous pouvons aspirer à des technologies qui favorisent l’équité et la justice sociale.

- ✓ La diversité demande une réponse technologique adaptée.

- ✓ Les biais intersectionnels nécessitent des méthodes de conception plus nuancées.

- ✓ L’Afrique doit jouer un rôle actif dans le façonnement de ses propres modèles d’IA pour garantir l’inclusivité.

Sources

Share this content:

Laisser un commentaire